Bereits Ende der 1940er Jahre dachte Donald Hebb über die Lernfähigkeit eines Netzes aus simulierten Neuronen nach. Später wurde dann, basierend auf diesem Gedanken und mit Hilfe eines mathematisch recht einfachen Ansatzes, das „machine learning“ entwickelt. Dabei werden künstliche neuronale Netze anhand von Testdaten darauf trainiert, Fragen zu beantworten und Aufgaben zu lösen. Da ein solches Training große Rechenkapazitäten benötigt, setzte der Siegeszug der KI erst ein, als entsprechend leistungsfähige Computer zur Verfügung standen.

Wie intelligent ist KI wirklich?

Wenn man staunend die immer neuen Höchstleistungen moderner KI-Systeme betrachtet, vergisst man leicht, dass künstliche Intelligenz auf einem vergleichsweise simplen mathematischen Ansatz beruht: Eine KI kann nur dann relevante Antworten geben, wenn sie vorher entsprechend trainiert wurde und anhand von Testdaten etwas über ein Problem gelernt hat. Das dazu erforderliche maschinelle Lernen („machine learning“, „ML“) stützt sich in der Regel auf künstliche neuronale Netze („artificial neural networks“, „ANN“).

Ihre Bezeichnung kommt nicht von ungefähr, denn neuronale Netze sind entstanden, als die erste Generation von Computerwissenschaftlern in den 1950er Jahren versuchte, ein mathematisches Modell für die Funktion der Neuronen im menschlichen Gehirn zu entwickeln. Bereits damals war es das Ziel der Entwickler, die Fähigkeiten biologischer Gehirne im Computer nachzubilden und so künstliche Intelligenz zu erzeugen. Als Urvater der neuronalen Netze gilt der kanadische Psychologe Donald Hebb, der bereits Ende der 1940er Jahre postulierte, dass ein Netz aus simulierten Neuronen, deren Verbindungen sich je nach Intensität der Impulsweiterleitung selbst verstärken, lernfähig sein müsste.

Kann die KI sich selbst trainieren?

Alle heute verwendeten generativen KI-Systeme basieren letztlich auf Hebbs Idee des künstlichen neuronalen Netzes, auch wenn dessen Architektur sich in den letzten Jahrzehnten gewandelt hat – hin zu vielschichtigen Netzwerken, die unter anderem mithilfe von Fehlerrückpropagation trainiert werden. Inzwischen werden für anspruchsvolle Aufgaben wie die Erzeugung von Bildern und Texten neuronale Netze von anderen neuronalen Netzen trainiert, etwa, indem ein System fehlerhafte Daten erzeugt, die ein anderes System als fehlerhaft erkennen muss. Koppelt man beide Systeme, wird das „Fake-System“ zu immer besseren Fälschungen angetrieben, die das Analyse-System gleichfalls immer besser werden lassen. Man spricht dann von einem generativen gegnerischen Netzwerk („generative adversarial network“, „GAN“).

Für viele Jahrzehnte war der Fortschritt beim maschinellen Lernen durch die vorhandene Rechenleistung eingeschränkt; dies traf insbesondere auf die Bereiche Bild- und Spracherkennung zu, die zu erlernen ein enormes Datenvolumen erfordert. Seitdem diese Barriere gefallen ist, erleben wir einen ungeahnten Siegeszug der künstlichen Intelligenz, die in vielen Bereichen der menschlichen Intelligenz den Rang abgelaufen hat. Da ist es vielleicht ein gewisser Trost, dass für all das die Nervenzellen des menschlichen Gehirns die Blaupause geliefert haben.

Bedeuten Quantencomputer und Kryptographie das Aus für sichere Kommunikation?

Quantencomputer und Kryptographie: Das klingt nach Science-Fiction und Verschwörungsthrillern à la Dan Brown. Tatsächlich werden Quantencomputer und die auf ihnen laufenden Algorithmen in naher Zukunft ganz realen Einfluss auf die Art und Weise haben, in der wir...

Wie kommt es zu einem Blackout?

In Berlin (Deutschland) kam es kürzlich zu einem tagelangen Stromausfall aufgrund eines terroristischen Anschlags. Es gibt – abgesehen von Sabotage oder Terrorakten – verschiedene physikalisch-technische Ursachen und Faktoren, die zu einem großflächigen Blackout...

Wie funktioniert die Stadieneinteilung bei Krebs?

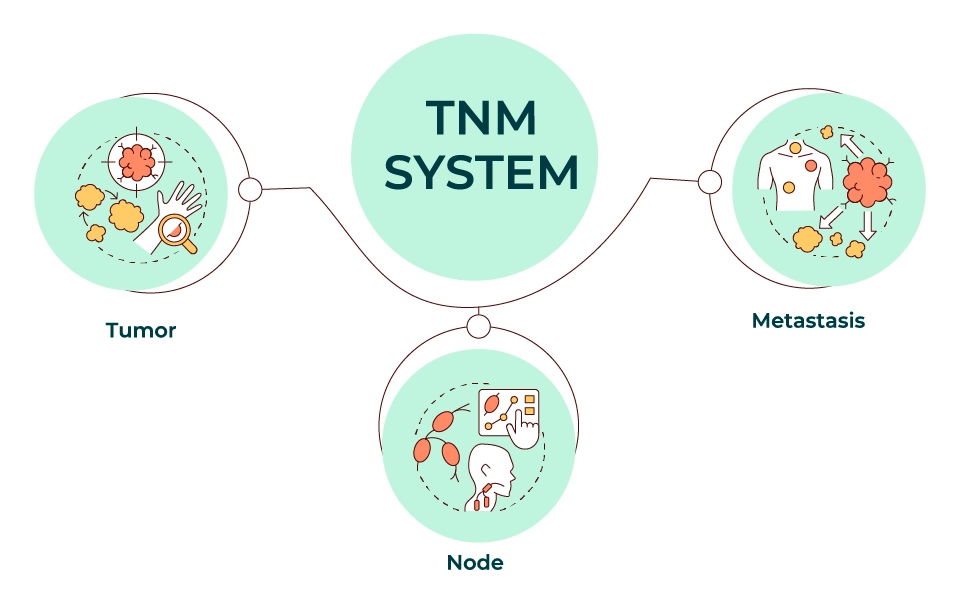

Heute ist für die Stadieneinteilung das sogenannte TNM-System maßgeblich. Es arbeitet mit den drei Kategorien „Primärtumor“ (englisch: „Tumor“), „Lymphknotenbefall“ („Node“) und „Metastasierung“ („Metastasis“). Die Stadieneinteilung bei Krebs war zunächst ein...

What Non-Nuclear Substance Is the Most Explosive?

Answering this questions leads us to the special competition: “Octanitrocubane (ONC) vs. the Rest”. It raises another question: How Do the Most Explosive Molecules Stack Up? In the world of energetic materials, few names spark as much curiosity—and awe—as...